在当今信息化快速发展的时代,数据的实时处理与分析已成为企业决策的重要基础。构建高效的pg国际流式ETL系统,不仅能够实现数据的及时采集、转换与加载,还能为企业提供更具价值的数据洞察。本文将从技术架构设计、数据源管理、实时数据处理及监控与优化四个方面详细探讨构建高效pg国际流式ETL系统的最佳实践,以期助力企业在复杂的数据环境中实现高效的数据运作和灵活的业务响应。

1、技术架构设计

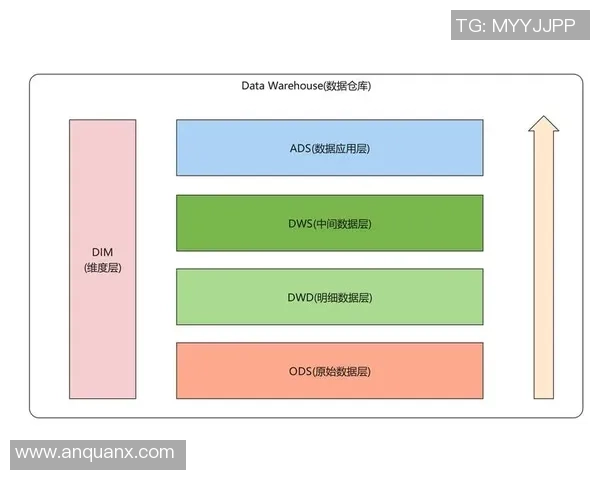

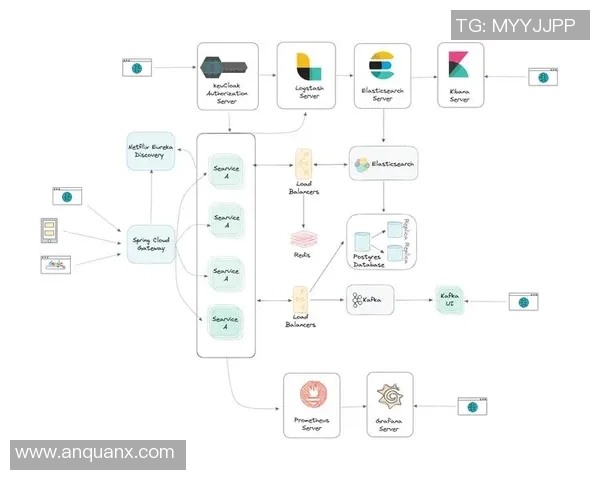

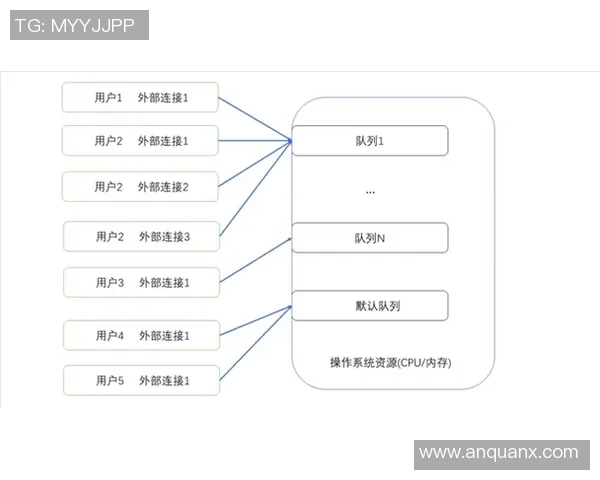

首先,技术架构是构建高效pg国际流式ETL系统的基石。在设计时,需要充分考虑系统的可扩展性和稳定性。选择合适的框架,例如Apache Kafka、Apache Flink等,可以保证在数据量激增时仍能有效地进行处理。这些工具不仅支持多种数据源接入,还能提供强大的消息队列功能,有利于实现异步处理,提高整体性能。

其次,在技术架构中应确保各个组件之间的解耦。通过微服务架构,可以将数据采集、转换和存储等模块独立开来,使得每个模块可以独立部署和维护。这种解耦设计不仅提高了系统的灵活性,也使得故障排查更加便捷,降低了系统停机时间。

最后,合理配置负载均衡机制也是保障技术架构高效运行的重要手段。通过对各个节点进行合理分配资源,可以避免某一节点过载而导致整体性能下降,从而提高系统的可靠性和可用性。

2、数据源管理

有效的数据源管理是实现实时数据处理的重要环节。在这一过程中,首先需要对接入的数据源进行全面评估,包括结构化与非结构化数据源,以及各种不同格式的数据,如JSON、XML等。了解这些特征后,可以选择最合适的数据转换方式,使得后续处理更加顺畅。

其次,为了确保数据质量,需要建立完善的数据清洗机制。在数据进入ETL流程之前,通过规则引擎或机器学习算法,对原始数据进行过滤和校验,以去除噪声和冗余信息,从而提升最终分析结果的准确性。

此外,要关注动态变化的数据源情况。当外部接口或数据库发生变更时,应及时更新ETL流程中的相应配置。这要求团队具备敏锐的信息捕捉能力,并能够迅速调整策略,以保证整个系统持续稳定运行。

3、实时数据处理

实时数据处理是pg国际流式ETL系统核心功能之一,其关键在于如何以最低延迟完成对海量数据的快速处理。可以利用流式计算框架,如Apache Flink,它支持事件驱动模型,使得每一条输入事件都可以即时触发对应操作,从而实现低延迟计算需求。

与此同时,聚合与窗口操作也是实现实时分析的重要手段。在实际应用中,可以根据业务需求设置不同类型的窗口(例如滚uu国际官网动窗口或滑动窗口),以便在固定时间区间内对入站流量进行统计分析,这样能够及时反映出动态变化趋势,为决策提供依据。

最后,要重视异常检测机制。在实时处理中,异常情况可能会影响整体业务逻辑,因此需要通过设定阈值或使用机器学习模型,对输入流中的异常行为进行自动识别。一旦发现异常,应立即采取措施,比如报警或逐步剔除问题记录,以确保整个流程不受干扰。

4、监控与优化

监控与优化是保障pg国际流式ETL系统长期健康运行的重要环节。首先,需要建立全面且精细化的监控体系,对每一个模块都要有相关指标跟踪,包括延迟时间、吞吐率以及错误率等。这些指标能够帮助工程师及时发现潜在问题并做出调整。

其次,通过日志管理工具收集运行过程中的详细日志信息,有助于后续问题排查及性能调优。当出现瓶颈时,可以通过分析日志深入了解具体原因,并据此优化相关代码或调整资源配置,以提高整体效率。

最后,还应定期开展性能测试与回顾,根据最新业务需求不断迭代优化。例如,当新增用户数量大幅增加时,可考虑横向扩展资源。同时,也要吸取过去经验教训,不断完善系统设计,实现持续改进。

总结:

综上所述,构建高效的pg国际流式ETL系统涉及多个方面,包括技术架构设计、数据源管理、实时数据处理以及监控与优化等,每一个环节都不可忽视。只有综合考虑各项因素,并结合实际业务需求制定相应策略,才能够真正提升企业在面对海量复杂数据信息时的快速反应能力和决策水平。

随着大数据时代的发展,企业对于实时分析能力提出了更高要求。因此,在未来的发展过程中,将继续探索新的技术方案,不断推进pg国际流式ETL系统建设,以保持竞争优势,实现更大的商业价值。